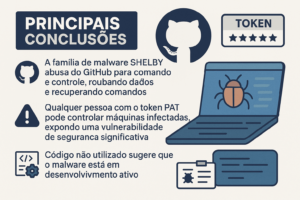

O ataque GhostStripe assombra carros autônomos, fazendo-os ignorar os sinais de trânsito

Câmeras testadas são especificadas para Apollo do Baidu

Seis especialistas vindos, em sua maioria, de universidades de Cingapura dizem que podem provar que é possível interferir em veículos autônomos, explorando a dependência das máquinas na visão computacional baseada em câmeras e fazendo com que não reconheçam os sinais de trânsito.

A técnica, apelidada de GhostStripe [PDF] em um artigo a ser apresentado na Conferência Internacional ACM sobre Sistemas Móveis no próximo mês, é indetectável ao olho humano, mas pode ser mortal para os motoristas Tesla e Baidu Apollo, pois explora os sensores empregados por ambos. marcas – especificamente sensores de câmera CMOS.

Basicamente, envolve o uso de LEDs para iluminar padrões de luz nos sinais de trânsito, de modo que o software de direção autônoma dos carros não consiga compreender os sinais; é um ataque adversário clássico a software de aprendizado de máquina.

Crucialmente, ele abusa do obturador digital dos sensores típicos de câmeras CMOS. Os LEDs piscam rapidamente em cores diferentes no sinal à medida que a linha de captura ativa desce pelo sensor. Por exemplo, o tom de vermelho em um sinal de pare pode parecer diferente em cada linha de varredura do carro devido à iluminação artificial.

A ilustração do artigo GhostStripe do ataque adversário ‘invisível’ contra o reconhecimento de sinais de trânsito de um carro autônomo

O resultado é uma câmera capturando uma imagem cheia de linhas que não combinam entre si como esperado. A imagem é recortada e enviada para um classificador dentro do software de direção autônoma do carro, que geralmente é baseado em redes neurais profundas, para interpretação. Como o snap está cheio de linhas que não parecem corretas, o classificador não reconhece a imagem como um sinal de trânsito e, portanto, o veículo não atua sobre ela.

Até agora, tudo isso já foi demonstrado antes.

No entanto, estes investigadores não só distorceram a aparência do sinal conforme descrito, como disseram que foram capazes de o fazer repetidamente de uma forma estável. Em vez de tentar confundir o classificador com um único quadro distorcido, a equipe conseguiu garantir que cada quadro capturado pelas câmeras parecesse estranho, tornando a técnica de ataque prática no mundo real.

“Um ataque estável… precisa controlar cuidadosamente a oscilação do LED com base nas informações sobre as operações da câmera da vítima e na estimativa em tempo real da posição e tamanho do sinal de trânsito no [campo de visão] da câmera”, explicaram os pesquisadores.

A equipe desenvolveu duas versões deste ataque estabilizado. O primeiro foi o GhostStripe1, que não requer acesso ao veículo, segundo nos disseram. Ele emprega um sistema de rastreamento para monitorar a localização do veículo alvo em tempo real e ajusta dinamicamente a oscilação do LED de acordo para garantir que um sinal não seja lido corretamente.

GhostStripe2 é direcionado e requer acesso ao veículo, o que talvez possa ser feito secretamente por um malfeitor enquanto o veículo está em manutenção. Envolve colocar um transdutor no fio de alimentação da câmera para detectar momentos de enquadramento e refinar o controle de tempo para realizar um ataque perfeito ou quase perfeito.

“Portanto, ele tem como alvo um veículo específico da vítima e controla os resultados de reconhecimento dos sinais de trânsito da vítima”, escreveram os acadêmicos.

A equipe testou seu sistema em uma estrada real e em um carro equipado com uma Leopard Imaging AR023ZWDR, a câmera usada no design de referência de hardware do Baidu Apollo. Eles testaram a configuração em sinais de parada, rendimento e limite de velocidade.

GhostStripe1 apresentou uma taxa de sucesso de 94% e GhostStripe2 uma taxa de sucesso de 97%, afirmam os pesquisadores.

Uma coisa digna de nota foi que a forte luz ambiente diminuiu o desempenho do ataque. “Essa degradação ocorre porque a luz de ataque é superada pela luz ambiente”, disse a equipe. Isso sugere que os malfeitores precisariam considerar cuidadosamente a hora e o local ao planejar um ataque.

Contramedidas estão disponíveis. Mais simplesmente, a câmera CMOS do obturador poderia ser substituída por um sensor que tira uma foto inteira de uma vez ou a varredura da linha poderia ser aleatória. Além disso, mais câmeras podem diminuir a taxa de sucesso ou exigir um hack mais complicado, ou o ataque pode ser incluído no treinamento de IA para que o sistema aprenda como lidar com ele.

O estudo se junta a outros que usaram informações adversárias para enganar as redes neurais de veículos autônomos, incluindo um que forçou um Tesla Model S a desviar de faixa .

A pesquisa indica que ainda há muitas questões de segurança de veículos autônomos e de IA a serem respondidas. O Register pediu ao Baidu que comentasse sobre seu sistema de câmera Apollo e apresentará um relatório caso uma resposta substancial se concretize. ®